Microprocessador

Conteudo

Introdução

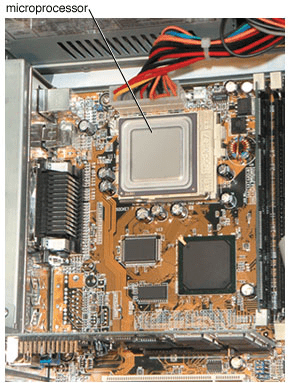

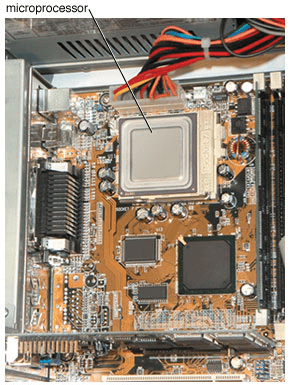

Um microprocessador é um pequeno computador contido em um circuito integrado, também chamado de chip semicondutor ou microchip. Ele pode funcionar como o “cérebro” de um computador pessoal de mesa. O microprocessador de um computador realiza operações aritméticas e lógicas, fornece armazenamento de memória temporário e regula todos os elementos do sistema de computador. Os microprocessadores são usados em muitos outros dispositivos eletrônicos, incluindo telefones celulares, utensílios de cozinha, controle de emissão de automóveis e dispositivos de cronometragem, jogos eletrônicos, sistemas de comutação de telefone, controles térmicos em casa e sistemas de segurança. Os microprocessadores foram possibilitados por técnicas avançadas de miniaturização de circuitos integrados, que podem combinar muitas funções eletrônicas e grande armazenamento de memória em um único chip muito menor do que um selo postal.

Um microprocessador é um pequeno computador contido em um circuito integrado, também chamado de chip semicondutor ou microchip. Ele pode funcionar como o “cérebro” de um computador pessoal de mesa. O microprocessador de um computador realiza operações aritméticas e lógicas, fornece armazenamento de memória temporário e regula todos os elementos do sistema de computador. Os microprocessadores são usados em muitos outros dispositivos eletrônicos, incluindo telefones celulares, utensílios de cozinha, controle de emissão de automóveis e dispositivos de cronometragem, jogos eletrônicos, sistemas de comutação de telefone, controles térmicos em casa e sistemas de segurança. Os microprocessadores foram possibilitados por técnicas avançadas de miniaturização de circuitos integrados, que podem combinar muitas funções eletrônicas e grande armazenamento de memória em um único chip muito menor do que um selo postal.

Design e Função

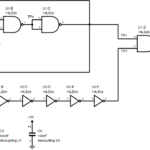

Um microprocessador consiste em um circuito integrado, que contém dispositivos ativos, como transistores, diodos ou circuitos lógicos, combinados com componentes passivos, como resistores e capacitores (consulte a eletrônica). A maioria dos microprocessadores usa um chip padrão, produzido em massa, com o programa específico integrado pelo fabricante como software. Esses microprocessadores são muito mais baratos de produzir do que microprocessadores especialmente projetados para uma única finalidade.

Todo esforço é feito para integrar tantos componentes eletrônicos e lógicos quanto possível dentro do chip e, assim, reduzir as conexões externas. Essas conexões são as peças de um microprocessador que estão mais sujeitas a falhas.

O processo principal no desenvolvimento de chips cada vez mais compactos é a microlitografia. Nesse processo, os circuitos são dispostos, geralmente com a ajuda de computadores, e depois fotograficamente reduzidos a um tamanho em que as linhas individuais do circuito tenham menos de um milésimo da largura de um cabelo humano. As primeiras técnicas de miniaturização, conhecidas como integração em grande escala (LSI), resultaram na produção do popular chip de memória de 256 Kb (kilobit ou mil bits). Na verdade, um chip de 256 Kb tinha uma capacidade de armazenamento de 262.144 bits, sendo cada bit um dígito binário, 1 ou 0 (consulte a eletrônica). Hoje, como resultado da integração em escala ultragrande (ULSI), podem ser feitos chips que contenham mais de um bilhão de transistores em uma área menor que 0,2 polegada (5 milímetros) quadrada. Esses chips podem armazenar muitos gigabytes – ou bilhões de bytes – de dados. (Um byte é um grupo de oito bits; consulte computador, “Bits, Bytes e o Sistema de Número Binário.”)

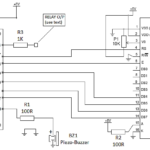

Como em grandes computadores, o coração do sistema microprocessado é a unidade central de processamento (CPU). A CPU executa três funções: dirige e monitora a operação do sistema; executa as operações algébricas ou lógicas necessárias; e serve como memória primária, armazenando informações que devem ser processadas. O próprio microprocessador pode atuar como CPU para um computador maior. (Consulte também computador, “Hardware”.)

Pode ser necessária memória de armazenamento adicional. Isso pode ser fornecido por outro chip na mesma placa de circuito impresso da CPU. Como todas as operações devem ser sincronizadas – ou seja, devem funcionar juntas na sequência correta – um relógio de oscilador de cristal também é instalado para regular o tempo.

Os microprocessadores usam diferentes números de bits para representar um símbolo (uma palavra, número ou comando). Comprimento da palavra é o termo usado para indicar o número de bits que são acoplados para formar um símbolo – quanto maior o comprimento da palavra, maior o número de padrões de bits diferentes disponíveis para uso.

Os primeiros microprocessadores eram processadores de 4 bits – eles podiam reconhecer grupos de quatro bits, ou 24 = 16 combinações binárias diferentes de 0s e 1s. Portanto, eles podem responder a 16 instruções operacionais diferentes. Essas unidades iniciais eram usadas em aplicações simples de controle e segurança. Em seguida, vieram os processadores de 8 bits, que eram os componentes básicos dos primeiros computadores pessoais, seguidos pelos processadores de 16 bits. Hoje, os processadores de 64 bits estão disponíveis, com quase 20 milhões de trilhões de combinações possíveis de dígitos binários por palavra.

Como resultado da crescente capacidade de armazenamento de bits dos chips, a distinção entre microprocessadores e minicomputadores tornou-se confusa. Na verdade, muitos microprocessadores atuais são mais poderosos do que os minicomputadores projetados no final dos anos 1970.

Um microprocessador armazena suas informações de maneiras diferentes, dependendo de como deve ser tratado. As informações que podem ser alteradas pelo usuário são armazenadas em uma parte da memória de acesso aleatório (RAM) do chip. O programa operacional real é normalmente armazenado na memória somente leitura (ROM) ou em uma matriz lógica permanente, uma vez que o usuário não precisa alterar este programa. As informações armazenadas na RAM são perdidas quando a fonte de alimentação é desconectada, enquanto as informações armazenadas na ROM são retidas mesmo se houver perda de energia.

Cada tipo de microprocessador possui um conjunto específico de instruções que ele entende. Uma instrução consiste em duas partes: um código operacional (código operacional) e um operando. O código op indica a operação a ser realizada; o operando especifica os dados a serem usados e indica onde eles devem ser armazenados.

Dentro do processador, essas instruções operam em linguagem de máquina ou em forma binária, consistindo apenas em padrões de 1s e 0s. Para aumentar a eficiência da programação e simplificar o uso, entretanto, a maioria dos programas é escrita em uma linguagem de alto nível, como BASIC, FORTRAN ou Java, que usa comandos baseados em palavras e notação matemática. Esses programas são então traduzidos no processador para a linguagem de máquina que a unidade entende e pode executar. Os programas de linguagem de alto nível também podem ser facilmente transferidos de um computador para outro.

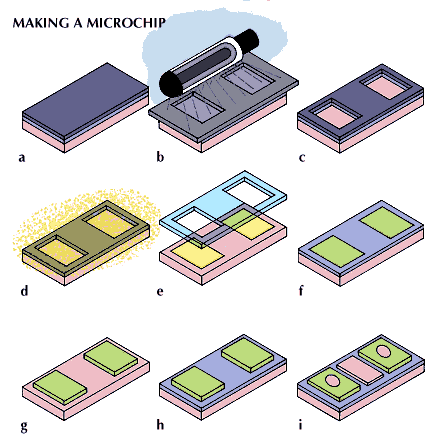

Fazendo um Chip

As aplicações de microprocessador têm crescido rapidamente desde os anos 1970. A maior parte desse crescimento se deve a melhorias na fabricação de chips, principalmente em litografia. O processo de produção típico começa com uma fina lâmina de silício, conhecida como substrato, que é coberta por uma fina camada metálica. Um polímero fotossensível, denominado resist, é então aplicado como um filme muito fino. Colocado sobre ele está um padrão microfotográfico das linhas do circuito a serem formadas, chamado de máscara. Após a exposição à luz ultravioleta, o wafer é desenvolvido. A máscara exposta, que não é protegida pela máscara, se dissolve e a pastilha abaixo é gravada para remover a película metálica. Isso deixa apenas linhas de circuito de metal no substrato de silício. Quanto mais estreitas essas linhas, mais elementos caberão em uma determinada área e menos tempo necessário para um sinal viajar de um componente para o outro – portanto, mais rápido o processador. Um processo litográfico semelhante é usado para depositar outros materiais em camadas especificadas em locais exatos

As aplicações de microprocessador têm crescido rapidamente desde os anos 1970. A maior parte desse crescimento se deve a melhorias na fabricação de chips, principalmente em litografia. O processo de produção típico começa com uma fina lâmina de silício, conhecida como substrato, que é coberta por uma fina camada metálica. Um polímero fotossensível, denominado resist, é então aplicado como um filme muito fino. Colocado sobre ele está um padrão microfotográfico das linhas do circuito a serem formadas, chamado de máscara. Após a exposição à luz ultravioleta, o wafer é desenvolvido. A máscara exposta, que não é protegida pela máscara, se dissolve e a pastilha abaixo é gravada para remover a película metálica. Isso deixa apenas linhas de circuito de metal no substrato de silício. Quanto mais estreitas essas linhas, mais elementos caberão em uma determinada área e menos tempo necessário para um sinal viajar de um componente para o outro – portanto, mais rápido o processador. Um processo litográfico semelhante é usado para depositar outros materiais em camadas especificadas em locais exatos

A cada poucos anos, o comprimento de onda da luz ultravioleta usada na produção de chips de computador diminuiu. Essa redução permitiu que os engenheiros gravassem linhas de circuito cada vez menores nos chips – e, portanto, geralmente correspondeu a um salto no número de transistores que podem ser colocados em cada chip.

Grande parte do custo de fabricação de circuitos integrados depende do volume de produção. Os chips devem ser montados em um suporte, que possui pinos para fazer as conexões elétricas, por meio de soquetes ou soldagem a outros componentes do sistema. Um grande número de pinos pode complicar a montagem da placa de circuito impresso. Como resultado, com a ajuda de robôs, a montagem moderna da placa foi amplamente automatizada para uma produção mais eficiente.

Evolução

A evolução do microprocessador rastreia a do computador eletrônico. Foi somente com a miniaturização dos circuitos integrados de semicondutores na década de 1960, entretanto, que o microprocessador moderno se tornou possível. O desenvolvimento de técnicas em grande escala (e posteriormente em escala muito grande e ultra grande) após 1970 reduziu o tamanho do circuito e permitiu circuitos mais complexos. Com isso, o microprocessador ganhou amplo uso em equipamentos eletrônicos e aceitação popular no escritório e em casa.

Na manufatura, os primeiros aplicativos de computador foram no controle de máquinas-ferramentas. As técnicas que direcionam os movimentos precisos de uma ferramenta também podem ser utilizadas para direcionar os movimentos de um dispositivo robótico, e é nesta aplicação que o microprocessador se destaca. Um microprocessador pode ser montado diretamente em um robô, instruindo-o a realizar operações armazenadas na memória do computador. Como resultado, os dispositivos robóticos controlados por microprocessador revolucionaram as técnicas de linha de montagem.